Видео с ютуба Optimizer And Learning Rate

Оптимизаторы - ОБЪЯСНЕНИЕ!

Оптимизация для глубокого обучения (Momentum, RMSprop, AdaGrad, Adam)

Who's Adam and What's He Optimizing? | Deep Dive into Optimizers for Machine Learning!

Gradient Descent in 3 minutes

Объяснение скорости обучения в нейронной сети

Which Loss Function, Optimizer and LR to Choose for Neural Networks

STOCHASTIC Gradient Descent (in 3 minutes)

Adam Optimizer Explained in Detail | Deep Learning

Gradient Descent Explained

Лучшие оптимизаторы для нейронных сетей

What are Optimizers in Deep Learning?

Gradient descent, how neural networks learn | Deep Learning Chapter 2

Алгоритм оптимизации Адама (C2W2L08)

Основы ИИ: точность, эпохи, скорость обучения, размер партии и потери

RMSprop Optimizer Explained in Detail | Deep Learning

Machine Learning Crash Course: Gradient Descent

![Adam Optimizer from scratch | Gradient descent made better | Foundations for ML [Lecture 26]](https://ricktube.ru/thumbnail/XHF2jW_U3iM/mqdefault.jpg)

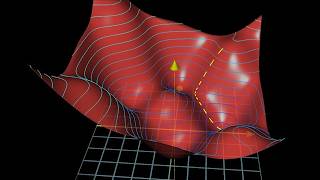

Adam Optimizer from scratch | Gradient descent made better | Foundations for ML [Lecture 26]